Как улучшить краулинговый бюджет | Статьи SEOnews

Оптимизация краулингового бюджета нужна, чтоб не расходовать его впустую, а привлечь сканирующих ботов на главные и нужные разделы и странички, исключить весь мусор из индекса.

В первой доли статьи рассказывали, как посчитать краулинговый бюджет, а в данной остановимся на советах, которые посодействуют предотвратить или ликвидировать технические оплошности на сайте. Это улучшает краулинговый бюджет и позитивно воздействует на ваши позиции в выдаче.

Наращивайте ссылочную массу

Обратные ссылки, которые водят на наш сайт с иных источников, подсобляют установить доверие с поисковыми системами и улучшить авторитет странички, что приводит к увеличению авторитетности сайта.

Это один из самых главных причин для SEO-продвижения. Наличие у странички обратных ссылок покажет поисковой системе, что сайту доверяют. Поисковый бот будет почаще навещать эти странички, и бюджет сканирования возрастет.

Получить ссылки с иных страничек можнож различными методами. Вот самые знаменитые:

- покупать ссылки на биржах;

- развивать крауд-маркетинг – располагать ссылки на форумах и блогах.

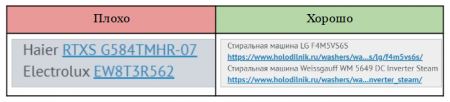

Ежели речь о крауд-маркетинге, ссылки необходимо располагать лишь на трастовых сайтах, которым доверяют поисковики. Делать это необходимо как можнож наиболее природно – без анкора. И даже ежели юзеру кажется, что анкорная ссылка смотрится наиболее природно, увы, поисковые системы считают напротив – они оценивают безанкорные ссылки.

Образцы положительного и отрицательного применения крауд-маркетинга на тематическом форуме

Мы в KINETICA придерживаемся всепригодной формулы анкор-листа: 20% анкорных ссылок и 80% безанкорных. На проектах стараемся сводить безанкорные ссылки к минимуму, миксуя их с брендовыми и анкорами-ключевиками.

Повысьте скорость сайта, чтоб убыстрить проверку страничек роботами

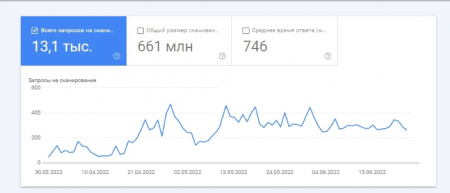

Чем прытче загружается сайт, тем прытче его просканирует бот. Это воздействует на количество обработанных URL – оно возрастет. Краулинговый бюджет, обычно, меняется прямо пропорционально медли, истраченному на одну страничку.

Скорость сайта можнож проверить в Google PageSpeed Insights. Сервис подскажет конкретные события, которые можнож предпринять для роста скорости загрузки.

На одном из наших проектов мы нашли, что бот расходовал на проверку одной странички 6 секунд. Это достаточно много. Напомним, юзер накрывает страничку спустя приблизительно 3 секунды. Мы устремляемся уменьшить это время до 2 секунд.

В Google PageSpeed Insights низкие результаты были по 2 показателям из 6: сервис отметил великий вес изображений и неподходящий формат – jpeg заместо webp и avif.

Мы детально углубились в вопросец и узнали: часть карточек продуктов индексировалась, а часть нет из-за того, что в каждой из их было от 5 изображений. Количество фото, их вес и формат затрудняли ботам сканирование.

Чтоб прирастить скорость загрузки, мы употребляли ускоренные странички. А для прыткой загрузки картинок мы их сжали и конвертировали, потом сохранили их в соотношении 0,25х, 0,5х, 0,75х, 1х, а потом настроили теги для выдачи рисунки в согласовании с размером экрана устройства.

Спустя полтора месяца мы отметили, что все карточки продуктов начали индексироваться в поисковиках. Бот начал расходовать на проверку одной странички 2 секунды. А потому что на сайте теснее присутствовало много полезного контента, отвечающего запросам юзеров, это вместе с ускорением загрузки воздействовало на краулинговый бюджет – он возрос в 3 раза.

Избавьтесь от проблемных кодов ответа, чтоб не расходовать время ботов на их проверку

Ежели контент находится на страничке, код ответа будет 200 («ОК») . Ежели нужна переадресация на иную страничку, код будет 301 («Перейти сюда вместо») . Эти коды числятся образцовыми, потому что водят бота к полезному контенту.

Но есть и проблемные коды, которые не демонстрируют контент, а просто расходуют время бота. К ним относятся:

1. 302 редирект – контент временно недоступен, но непременно покажется. К примеру, летом вы убрали раздел с шубами и пуховиками. А бот все лето будет стучаться к вам на сайт в ожидании (как Хатико) контента на этих страничках.

Ежели на вашем сайте есть странички с кодом ответа 302, советуем проверить их и настроить на 301 редирект. С течением времени 301 закончат сканироваться и заменятся на целевые, и бот не будет каждый разов проверять страничку в ожидании контента.

2. 404 код – страничка не найдена. По факту это колоченные ссылки, от которых надобно избавляться. Бот будет временами навещать эти странички, ведь ему дается сигнал, что, вероятно, страничка покажется позднее.

3. 500 код – сервер недоступен. Это явный признак плохого ресурса, на который бот будет заходить все реже для сканирования.

Такие коды расходуют время краулера на определение их ответа. Это приводит к тому, что на обход подходящих страничек у бота не хватает медли.

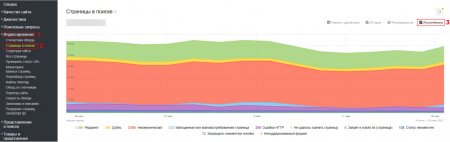

А еще советуем удалить негодные странички с сайта. Проверить их наличие можнож в Яндекс Вебмастере. Сервис посчитает страничку негодной, ежели она является дублем, не содержит видимый боту контент или контент просто не нужен.

Заходим в «Индексирование» -> «Странички в поиске» -> «Исключенные».

Потом обретаем в перечне показатель «Негодная или маловостребованная страница». На проекте по продвижению интернет-магазина одежды и обуви он оказался 3,77%. Это хороший итог и представлен он был, в главном, колоченными ссылками (код 404) , которые мы потом удалили.

Ежели ваш показатель от 20%, советуем колотить тревогу – вероятно, к колоченным ссылкам добавятся дубли страничек и тайный контент. Когда четверть сайта представляет из себя негодные странички, боты могут утратить к нему доверие. Необходимо как можнож быстрее выявить предпосылки и ликвидировать их, чтоб не утрачивать в индексации.

Актуализируйте robots и sitemap, чтоб бот сообразил структуру сайта

Robots и sitemap – это xml-файлы, которые подсобляют поисковым ботам верно просканировать сайт и лучше понять его структуру:

- В файле robots.txt накрывают мусорные странички, дубли, странички пагинации. Боты усвоют, что не надо расходовать на их проверку время. Так мы сэкономим краулинговый бюджет.

- В файле sitemap прописывают все странички сайта, которые необходимо проиндексировать. Он носит рекомендательный нрав и дает понять боту ценность по сканированию.

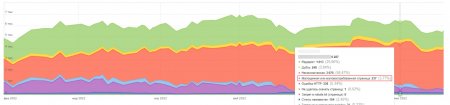

На одном из проектов, который зашел к нам на аудит, мы нашли полное неимение robots и sitemap. Сканирование и индексация сайта проходили чрезвычайно медлительно и неэффективно из-за переезда с 1-го домена на иной и великого количества редиректов. Юзерам это было незначительно, а боты пробовали исследовать все странички, расходуя на это бюджет.

Опосля внедрения robots и sitemap количество обращений роботов к сайту со 100 подросло до 300. Краулинговый бюджет возрос в 3 раза, отчего улучшилось сканирование сайта в целом.

Удалите цепочки редиректов

Редиректы остаются хорошим решением заморочек с переадресацией:

- При наличии дублей страничек предоставляют понять боту, на какую страничку смотреть. Ежели ранее бот регистрировал по одному запросу две странички, то сейчас он будет знать, что есть одна трафиковая страничка, а все другие переехали на нее.

- Поможет выслать бота или юзера на действующую страницу. Актуально, ежели мы удалили страничку с оплошностями (код 404) , но с превосходными поведенческими факторами и которую глядели боты. Так мы бережём трафик на подходящей нам страничке.

Но бот при получении редиректа 301 пройдет по всем URL в цепочке и израсходует ваш краулинговый бюджет. Объясняем – бот увидит первую ссылку, а вторую – опосля перехода на нее. И лишь опосля этого перейдет на страничку с правильным URL.

Цепочка редиректов запутает бота не дозволит ему сходу попасть на подходящую страничку. Повторимся, речь тут конкретно о нескольких страничках с кодом 301, но не о одном редиректе.

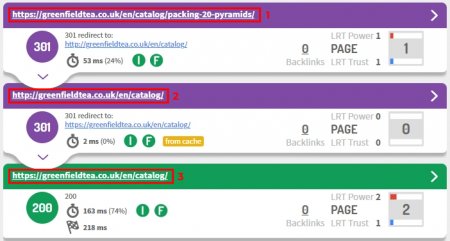

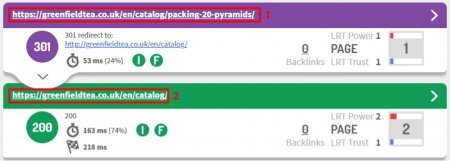

На скрине видно 3 странички на сайте: две фиолетовых – две странички с редиректом, одна зеленоватая – окончательная страничка. Шаг 2 на скрине излишний и отбирает время бота во время сканирования

А представьте, что таковых цепочек будет много – юзеру это не приметно, но бот будет принуждён переходить от ссылки к ссылке, чтоб отыскать подходящую страничку.

Мы в KINETICA настраиваем редиректы так, чтоб они высылали бота сходу на релевантную страничку. Другими словами не создаем цепочки, а используем код 301 лишь один разов перед окончательным URL. Кроме этого мы убираем все ссылки с сайта на страничку с кодом 301.

Удалили цепочку редиректов, оставив перед целевой страничкой лишь одну с кодом 301

С течением времени странички редиректов уходят из поля зрения поисковиков и индексируются лишь окончательные URL. Это дозволяет сохранить краулинговый бюджет.

Настройте перелинковку на главные странички сайта

При сканировании и индексировании сайта бот почаще всего дает предпочтение страничкам, которые имеют вес. Чтоб его создать, необходимо настраивать перелинковку меж страничками.

Мы используем неповторимые и разнородные анкоры с ключевиками и прибавляем ссылки на странички, подходящие теме. По нашему опыту, наилучшее число внутренних ссылок на страничку – от 7 штук.

Грамотная структура увеличивает значимость страничек, обращая ссылочный вес в подходящий раздел при поддержки перелинковки. Краулерам это подсобляет выискать нужные странички без излишнего расходования бюджета, а юзеру – живо добиться подходящую страничку. Это улучшает юзабилити сайта и поведенческие метрики, что будет сигналом для ПС к увеличению бюджета.

Разместите заголовок Last-Modified, чтоб поведать ботам о конфигурациях на странице

Заголовок Last-Modified извещает браузеру юзера или боту ПС информацию о дате и медли заключительного конфигурации текущей странички.

Ах так он смотрится:

Шаблон Last-Modified: <день недели>, <число> <название месяца> <год> <час>:<минута>:<секунда> GMT

Пример Last-Modified: Thu, 19 May 2022 13:23:00 GMT

Оптимизация краулингового бюджета в данном варианте происходит за счет того, что бот вначале осмысливает, какие странички добавлялись не так давно или редактировались. И заместо того, чтоб обходить весь сайт, индексация происходит точечно. Это необыкновенно главно для страничек с великим количеством страничек.

При прибавлении заголовка ускоряется загрузка странички и снижается перегрузка на сервер, а означает, веско ускоряется скорость индексации странички.

Определите главную страничку и склейте дубли, чтоб бот просканировал страничку с великим трафиком

Во время сканирования бот может отыскать дубли страничек – одну и ту же страничку под различными URL-адресами. В окончательном счете он даст предпочтение одной из их.

Казалось бы, все превосходно, но пока следует сканирование и индексация сайта, на дубли расходуется краулинговый бюджет. Ежели таковых страничек немножко, это не критично. Но для больших страничек наличие дублей может приметно сказаться на скорости индексации. К тому же, бот может сам выбрать в качестве главной страничку, которую нам продвигать не надо.

На проекте по продвижению светового оборудования мы определили пул дублей страничек. К одним и этим же товарам юзер мог дойти различными маршрутами. К примеру, к определенному светильнику – через категорию светильников или через категорию брендов. Другими словами продукт один, а карточки различные.

Мы определили странички, которые посреди дублей приносили больше трафика и сделали их главными. На другие же поставили атрибут rel="canonical" с адресом главной странички.

Склейка дублей дозволила сохранить число страничек в индексе, при всем этом не навредить репутации сайта великим количеством неуникального контента.

Поправьте оставшиеся недостатки технической оптимизации

Недостатки внутренней оптимизации могут быть некритичны для малого сайта, но с ростом их количества и масштаба сайта они будут творить делему – расходовать время поискового бота и усугублять индексацию сайта. Их необходимо ликвидировать.

Избавьтесь от цикличных ссылок, чтоб не вводить в заблуждение пользователей

Цикличная ссылка – та, что ссылается сама на себя. К примеру, вы находитесь на страничке с белоснежной футболкой -> чуток ниже вам предоставляют перейти на страничку с иной белоснежной футболкой -> вы переходите и попадаете на бывшую страничку и никакой иной футболки не видите.

Во-1-х, это вводит в заблуждение юзера и сердит его, потому что он расходует свое время на поиск. Во-2-х, это приводит к растрате ссылочного веса и расходу краулингового бюджета.

Для великих страничек это является критическим моментом, потому что может значительно воздействовать на скорость обхода и индексирование страничек.

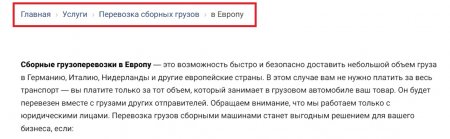

Почаще всего циклические ссылки встречаются в хлебных крошках – навигационной цепочке, когда ее хвост кончается активной ссылкой на текущую страничку. Так делать не надо – цикличную ссылку необходимо убрать.

На фразе «в Европу» отсутствует цикличная ссылка, потому страничка не ссылается сама на себя – это правильно

Проставьте ссылки на потерянные странички, чтоб юзеры и боты смогли вас найти

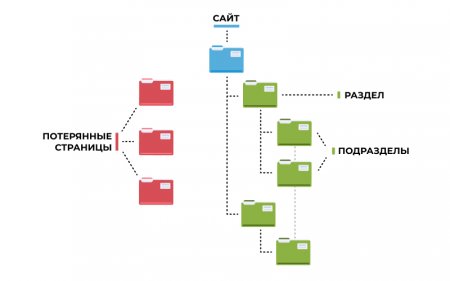

Потерянные страницы – это странички, на которые невероятно попасть через внутренние ссылки. Из-за этого юзеры и боты не сумеют их отыскать.

Наглядно они смотрятся так:

При обнаружении таковых страничек проанализируйте их:

- если потерянная страничка нужна, проставьте на нее ссылки и передайте тем самым внутренний вес с сайта;

- если потерянная страничка не нужна, удалите ее.

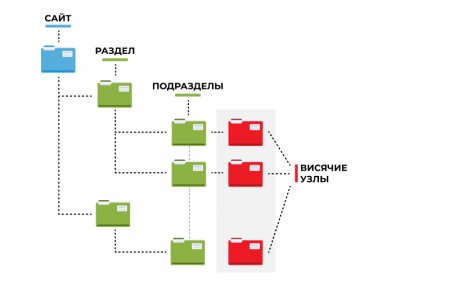

Удалите висящие узлы, чтоб не утрачивать ссылочный вес страниц

Висящий узел – это страничка без исходящих ссылок. Она воспринимает ссылочный вес, но никуда его не дает. Вы будто видите на сайте перечень со статьями на различные темы, переходите на эти странички и доходите до странички, с которой никуда не перейти.

Юзеру в данном варианте просто неловко – чтоб возвратиться на предыдущую страничку, ему придется надавить клавишу «назад» или зайти в поиск. А бот в данном варианте окажется в тупике, ведь ему некуда переходить со странички, а надавить на клавишу «назад» он не может.

Почаще всего висящие узлы не представляют суровой трудности, но необходимо проанализировать нрав таковой странички и по способности внести корректировки:

- если на страничке содержится контент, который не поместился на главную страницу, удалите висящий узел, вполне перенеся контент на главную страничку;

- если на страничке содержится подходящий контент, добавьте на нее наружные ссылки на главные разделы сайта.

Наглядно они смотрятся так:

Приготовьтесь к постоянной оптимизации

Поддержание технической оптимизации сайта – процесс безграничный, потому надобно быть готовым непрерывно вносить правки и отслеживать улучшения.

Ловите наш чек-лист технической оптимизации и используйте его в работе. Это воздействует на краулинговый бюджет и последующее ранжирование вашего сайта.

Статьи

Комментариев 0