4 метода живо смонтировать теги для сайта | SEO кейсы: социалки, реклама, инструкция

Тегирование сайта — процесс творения страничек для сортировки материалов/товаров по похожим признакам.

Этот способ подходит для таковых типов страничек, как:

- интернет-магазины,

- доски объявлений,

- информационные сайты с великим количеством статей,

- порталы.

Целями творения тегов являются:

- увеличение трафика методом творения доп страничек(точек входа);

- улучшение навигации;

- рост конверсии и удовлетворенности юзера.

В данной статье мы осмотрим методы, как можнож живо смонтировать теги для сайта.

Как живо смонтировать теги

1. Смонтировать перечень страничек для сбора тегов.

2. Получить теги с выбранного перечня страничек.

3. Приготовить файл с заглавием тега, URL странички, h1, title, description, хлебными крошками.

Как отыскать сайты для сбора тегов

1. Выдача поисковых систем по главному запросу

Вводим в поисковую систему(Яндекс, Google)главной запрос, изучаем сайты на предмет тегов.

Пример главного запроса — «платья».

В неких вариантах находятся карты сайта, где имеются ссылки на странички всех тегов, имеет смысл их поискать. Эти же сайты в последующем можнож применять для поиска тегов и для иных запросов.

2. Выдача поисковых систем по запросу для странички тега

Вводим в поисковую систему(Яндекс, Google)запрос для странички тега, изучаем сайты на предмет тегов.

Пример запроса для странички тега — «платья с длинноватым рукавом».

3. Сервисы

Можнож применять сервисы, где видно соперников со похожими ключами.

К примеру — keys.so.

В качестве образца приведу перечень сайтов-конкурентов для интернет-магазина по продаже одежды. Характеристики похожести и тематичности подбираются в зависимости от проекта.

В данном образце:

- Мы оставляем сайты с тематичностью от 30 %. Тематичность — сколько процентов наших ключей имется на сайте соперника.

- Фильтрацию по похожести не производим, потому что наш сайт находится на исходной стадии развития, а соперники, продающие одежду, имеют чрезвычайно великое количество запросов в топе. Похожесть — процент общих ключей от всех ключей сайта соперника.

- Проходимся по сайтам и убираем те, которые нам не подходят.

Выгрузка по фильтрам из сервиса keys.so

Как получить теги с выбранного перечня сайтов

Для сбора большего количества тегов во всех методах рекомендуется применять как минимум несколько страничек. Есть различные варианты, как можнож получить теги с определенного сайта.

1. Скопировать вручную

Заходим на сайты соперников и вручную копируем наименования.

Я осмотрю тему на образце маленького количества запросов, чтоб было проще принимать информацию, при всем этом чрезвычайно усложню задачку, добавив главные трудности, с которыми можнож столкнуться.

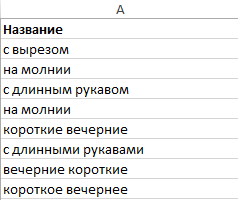

Создаем Excel-файл, «столбик А» именуем «Название». Копируем туда теги с различных страничек.

Теги с различных сайтов

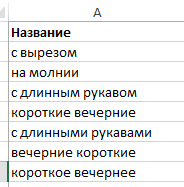

Далее устраняем явные дубли(на молнии = на молнии), разумея, что у нас еще останутся неявные дубли.

Теги без явных дублей

Наполняем наименования других столбиков:

B — URL

C — h1

D — description

E — Ч

F — Ч “”

G — Путь

Заглавия таблицы

В итоге получаем поля:

Название — заглавие тега, которое будет показываться на страничке, где на него будет стоять ссылка. К примеру, на страничке «Платья» выводятся ссылки на теги.

Вывод тегов на сайте

URL — URL тега

h1 — h1, он же заголовок страницы

description — поле, данные из которого будут употребляться для генерации метатега description

Ч — общественная частотность по Вордстату(запрос)

«Ч» — частотность данной фразы с учетом всех морфологических форм(«запрос»)

Путь — размещение тега на сайте = хлебные крошки

Наполняем по порядку.

h1 — к значению в поле «Название» прибавляем слово «платья».

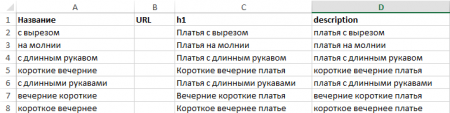

Таблица со значениями h1

В данном случае для генерации title употребляется значение из поля h1, потому он не представлен в таблице.

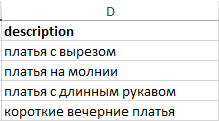

description — используем данные из столбика h1 и делаем первую букву малюсенькой. Для этого используем функцию «СТРОЧН» в Excel.

Таблица со значениями h1 и description

С внедрением значений из этого поля пишем генератор description.

Запросы из столбика description прибавляем в Key Collector. Отмечаем неявные дубли.

Вручную устраняем неявные дубли из нашей таблицы. Традиционно неявные дубли встречаются в маленьких количествах, потому это нетрудно сделать.

В итоге остается:

Столбик description

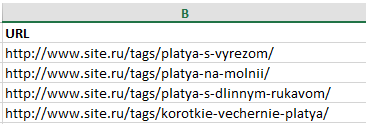

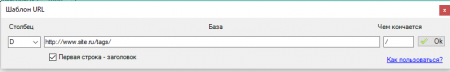

URL — генерируем, используя функцию URL от Seo-Excel из поля description.

Поля для ввода данных при генерации URL в SEO-Excel

Получаем:

Сгенерированные URL

Ч и «Ч» — снимаем частотность хоть каким комфортным прибором или обслуживанием.

Ч — используем для удаления запросов, не имеющих частотности. Для сезонных запросов можнож дополнительно снимать частотность по месяцам.

«Ч» — используем для понимания, не является ли данный запрос сочиняющей иного запроса(вероятно такового запроса не существует).

Путь — для данного проекта теги лежат снутри главного раздела.

Прибавляем «Основная — Платьица — » и позже то, что следует в h1.

В случае с вложенными тегами(когда один тег вложен в иной)путь может изменяться.

К примеру, для запроса «Краткие вечерние платья» путь будет «Основная — Платьица — Вечерние платьица — Краткие вечерние платья».

Таблица с заполненным столбиком «Путь»

Там же в зависимости от выбранного метода вывода ссылок может изменяться заглавие:

- если оно выводится на страничке всех платьев, оно может иметь заглавие «короткие вечерние»;

- если на страничке вечерних платьев, то «короткие».

С образцом, разобранным в задачке, можнож ознакомиться в Google Docs.

Плюсы:

- просто;

- не требуются доп программы;

- хорошо подходит для страничек с необычной URL-структурой.

Минусы:

- больше ручной работы.

2. Парсинг програмкой Screaming Frog SEO Spider

Для исполнения данного пт будет нужно программа Screaming Frog SEO Spider(платная).

Настройка

Осмотрим пример парсинга тегов со странички Платья на сайте www.wildberries.ru.

Для начала в програмке нам необходимо заполнить две опции.

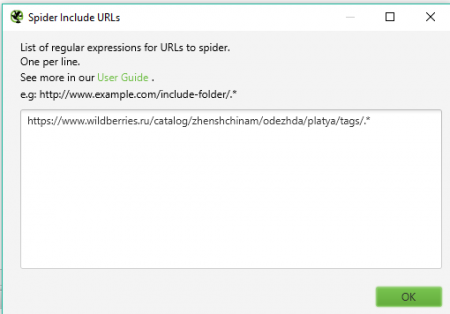

Configuration — Include(Верховодила включения)

Сюда мы добавим URL, с которых начинаются теги. Эти теги будет прибавлять программа.

Все теги на страничке платьев начинаются с такового URL: https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya/tags/

Прибавляем таковым образом:

https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya/tags/.* |

Окно для ввода характеристик в «Верховодила включения» в Screaming Frog SEO Spider

Configuration — Exclude(Верховодила исключения)

Наша задачка состоит в том, чтоб исключить странички пагинации, сортировки и странички такового типа, которые по смыслу дублируют главную страничку. Такие странички не несут смысла для нашей задачки.

Исключаем по элементам, которые содержатся в URL: .*%элемент в URL%.*

У меня вышло так:

.*page-.* .*page=.* .*pagesize=.* |

Окно для ввода характеристик в «Верховодила исключения» в Screaming Frog SEO Spider

С течением времени соберется великий перечень таковых характеристик, и это упростит работу.

Парсинг

Вбиваем URL главной странички и давим «Start»: https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya

Окно ввода URL в Screaming Frog SEO Spider

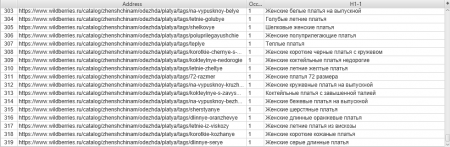

Получаем перечень из 313 страничек тегов по Платьицам с наименованиями.

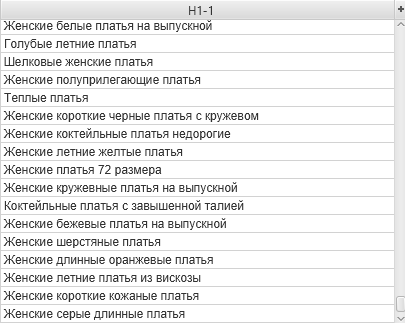

Значения вкладки «h1» в Screaming Frog SEO Spider

Далее теснее можем работать с тегами h1.

Значения столбика H1-1 вкладки «h1» в Screaming Frog SEO Spider

С образцом приобретенного результата можнож ознакомиться в Google Docs.

Скорость ответа сервера у большинства страничек с тегами прыткая. Потому скорость парсинга будет зависеть от:

- настроек программы,

- мощности компа,

- наличия охраны от DDoS на сайтах.

Плюсы:

- программный сбор инфы.

Минусы:

- нужна платная программа Screaming Frog SEO Spider;

- требуется настройка характеристик исключения для страничек, дублирующих главную(пагинация, фильтры, сортировки);

- не у всех страничек комфортная URL-структура для парсинга тегов.

3. Парсинг из поисковой системы

Сбор страничек, начинающихся с определенного URL, из выдачи поисковой системы.

Для просмотра страничек необходимо задать запрос вида:

url:%URL с которого начинаются странички тегов%* |

К примеру, чтоб поглядеть теги со странички Платья на сайте www.wildberries.ru, необходимо задать запрос вида:

url:https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya/tags/* |

Ограничение Яндекса — не наиболее 1000 результатов, потому ежели в выдаче наиболее 1000 результатов, то парсим, хоть каким образом ограничивая количество результатов, к примеру, побуквенно.

Ежели бы у нас было наиболее 1000 результатов, мы собирали таковым образом:

url:https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya/tags/a* |

url:https://www.wildberries.ru/catalog/zhenshchinam/odezhda/platya/tags/b* |

Парсить выдачу можнож через Key Collector.

Для совершенно маленьких страничек при парсинге по буквам или по каким-то маленьким кластерам можнож применять выгрузку ТОП-100 страничек по запросу в ПС Yandex от сайта Arsenkin.ru(живо и безвозмездно). Далее для этих страничек парсим h1 через SeoPult.

Плюсы:

- программный сбор информации

Минусы:

- не все странички, которые есть на сайте, могут быть проиндексированы;

- для неких страничек требуется удалить странички, дублирующие главную(пагинация, фильтры, сортировки);

- не у всех страничек комфортная URL-структура для парсинга тегов.

4. Парсинг по элементу URL в keys.so

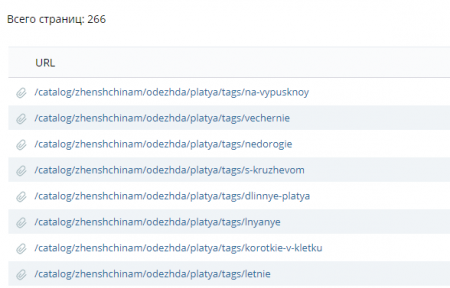

Сбор страничек с определенным URL в сервисе keys.so.

1. Делаем отчет по сайту.

2. Глядим отчет, где показываются все странички сайта.

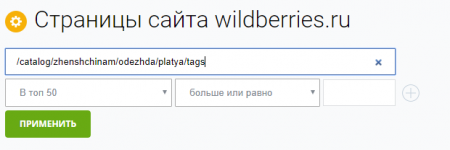

3. Фильтруем по полю «Адресок содержит», вбивая подходящий элемент URL, чтоб показывались лишь теги.

Фильтр в образце:

/catalog/zhenshchinam/odezhda/platya/tags |

Поле для задания фильтров в сервисе keys.so

Перечень отфильтрованных страничек в сервисе keys.so

Далее для этих страничек парсим h1 через SeoPult.

Плюсы:

- сбор инфы через сервис;

- обычно отсутствуют странички, дублирующие главную(пагинация, фильтры, сортировки).

Минусы:

- нужен доступ в Keys.so(платный);

- сервис указывает не многие странички, которые есть на сайте, а лишь те, где есть желая бы 1 ключевое слово в ТОП 50;

- не у всех страничек комфортная URL-структура для парсинга тегов.

Вывод

Мы осмотрели 4 метода прыткого сбора тегов для сайта. Эти методы дозволяют сэкономить время на сборе и творении страничек тегов, сделав это прытче, чем занимаясь ручной разгруппировкой семантического ядра. У каждого метода свои плюсы и минусы. Выбор метода зависит от задачки и имеющегося комплекта приборов и сервисов.

Ежели есть какие-то вопросцы или предложения, как можнож сделать лучше, предлагаю обсудить в комментах.

Комментариев 0